ディープラーニングの精度向上に役立つ!KerasのLambdaレイヤーによるカスタムレイヤー

初めに

Kerasのディープラーニングモデルで利用できるカスタムレイヤーの一つ、Lambdaレイヤーについて詳しく解説します。

※ この記事はディープラーニングおよびKerasの知識がある方向けのリファレンスになります。

カスタムレイヤーとは?

カスタムレイヤーとは、Kerasが標準で提供するレイヤー以外の独自のレイヤーを作成するための機能です。Kerasでは、Lambdaレイヤーを使用してカスタムレイヤーを構築します。

カスタムレイヤーが必要な理由

Kerasはディープラーニングモデル構築に必要な様々なレイヤーを標準で提供していますが、Kerasの標準レイヤーでは表現できない特定の操作やロジックをモデルに追加することで、モデルの精度向上が見込める場合があります。このような場合にカスタムレイヤーが必要となります。

以下に、カスタムレイヤーが必要となる具体的な例と、そのメリットを紹介します。

1. カスタム活性化関数

ReLUやSigmoidなどの標準的な活性化関数とは異なる活性化関数を使用したい場合に用います。特定のデータセットやタスクに最適化された活性化関数を実装することで、モデルのパフォーマンスが向上する可能性があります。

kerasの標準にはない活性化関数の例

-

Swish

swish(𝑥)=𝑥⋅sigmoid(𝑥)

Swishは学習が進むにつれてスムーズな非線形性を持つため、ReLUよりも高い性能を示すことがある。 -

Mish

mish(𝑥)=𝑥⋅tanh(softplus(𝑥))

Mishは滑らかで非対称な活性化関数。多くのタスクで高い性能を示すことが報告されています。 -

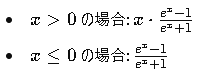

ELiSH (Exponential Linear Squashing)

ELiSHは正負で異なる形状を持つことで、特徴の学習がしやすい活性化関数です。 -

HardSigmoid

hardsigmoid(x)=max(0,min(1,0.2x+0.5))

HardSigmoidは計算が効率的なため、リソースが限られた環境での使用が適しています。

2. カスタム正規化

バッチ正規化やレイヤー正規化とは異なる正規化方法を使用したい場合に用います。特定のデータセットやタスクに適した正規化方法を実装することで、モデルのパフォーマンスが向上する可能性があります。

kerasの標準にはないカスタム正規化の例

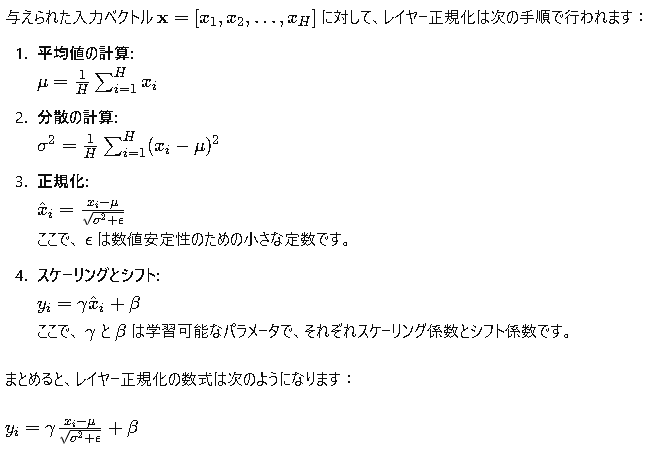

- レイヤー正規化 (Layer Normalization)

各層ごとに正規化を行う手法で、特にRNNやTransformerモデルでよく用いられます。レイヤー正規化により、各サンプルの各特徴量が平均0、分散1に正規化され、スケーリングとシフトにより適応的に調整されます。

レイヤー正規化を数式で表すと以下になります。

3. カスタム損失関数

平均二乗誤差や交差エントロピーなどの標準的な損失関数とは異なる損失関数を使用したい場合に用います。特定のデータセットやタスクに適した損失関数を実装することで、モデルのパフォーマンスが向上する可能性があります。

kerasの標準にないカスタム損失関数の例

- ハバード損失 (Huber Loss)

回帰問題において広く使用されるロバストな損失関数です。平均二乗誤差(MSE)と平均絶対誤差(MAE)の両方の利点を兼ね備えており、外れ値に対してよりロバストです。ハバード損失は、誤差が小さい場合は二乗誤差を使用し、誤差が大きい場合は絶対誤差を使用します。

4. 特殊な処理

データの前処理、後処理、または特殊な操作を実行したい場合に、データを特定の方法で変換するレイヤーを作成します。

kerasのカスタムレイヤー

カスタムレイヤーの作成方法

カスタムレイヤーは、tf.keras.layers.Layerクラスを継承して作成できます。

tf.keras.layers.Layer抽象クラス

関数

- init(self, kwargs): レイヤーの初期化を行います。kwargs には、レイヤーの構成情報 (ユニット数、活性化関数など) を渡すことができます。

- build(self, input_shape): レイヤーの重みとバイアスなどのパラメータを構築します。入力テンソルの形状 (input_shape) を受け取り、レイヤーの重みとバイアスを初期化します。

- call(self, inputs): レイヤーのフォワードパスを実行します。入力テンソル (inputs) を受け取り、レイヤーの出力テンソルを返します。

- compute_output_shape(self, input_shape): レイヤーの出力テンソルの形状を計算します。入力テンソルの形状 (input_shape) を受け取り、出力テンソルの形状を返します。

- get_config(self): レイヤーの構成情報 (ユニット数、活性化関数など) を辞書形式で返します。

- from_config(self, config): 辞書形式の構成情報 (config) からレイヤーを復元します。

属性

- trainable_weights: 学習可能な重みとバイアスのリストです。

- non_trainable_weights: 学習不可な重みとバイアスのリストです。

- weights: trainable_weights と non_trainable_weights を合わせたリストです。

- input_shape: レイヤーへの入力テンソルの形状です。

- output_shape: レイヤーからの出力テンソルの形状です。

- name: レイヤーの名前です。

- dtype: レイヤーのデータ型です。

カスタムレイヤーの実装例

tf.keras.layers.Layerクラスのcallメソッドを実装することで、レイヤーの動作を定義します。buildメソッドを使用して、レイヤーの重みやバイアスなどのパラメータを初期化します。

import tensorflow as tf

class MyCustomLayer(tf.keras.layers.Layer):

# レイヤーの定義

# この例の場合、unitsをパラメタに取るレイヤー

def __init__(self, units=32, **kwargs):

super(MyCustomLayer, self).__init__(**kwargs)

self.units = units

# レイヤーの重みとバイアスの構築。

def build(self, input_shape):

# 重みをランダム正規分布で初期化。

self.w = self.add_weight(

shape=(input_shape[-1], self.units),

initializer='random_normal',

trainable=True,

name='w')

# バイアスをゼロで初期化。

self.b = self.add_weight(

shape=(self.units,),

initializer='zeros',

trainable=True,

name='b'

)

# 構築完了をマーク。

super(MyCustomLayer, self).build(input_shape)

# レイヤーのフォワードパス

def call(self, inputs):

# 入力と重みを掛け合わせてバイアスを加算。

return tf.matmul(inputs, self.w) + self.b

# レイヤーの設定を取得

def get_config(self):

# 親クラスの設定を取得。

config = super(MyCustomLayer, self).get_config()

# units を設定に追加。

config.update({'units': self.units})

# 設定を返す。

return config

カスタムレイヤーの呼び出し

カスタムレイヤーは、他の標準レイヤーと同様に、Kerasモデルに直接追加できます。

from keras.models import Sequential

model = Sequential()

model.add(MyCustomLayer(units=64))

model.add(Dense(10, activation='softmax'))Lambdaレイヤーの利点

- 柔軟性: 任意の関数をレイヤーとして実装できます。

- 簡潔性: カスタムレイヤーを作成するためのコード量が削減されます。

- 再利用性: 複数のモデルで同じLambdaレイヤーを再利用できます。

Kerasリファレンス

Kerasの詳しい使い方は本家の以下ページを参照下さい。

https://keras.io/api/

最後に

本記事がAIの理解に少しでもお役に立てば幸いです。機械学習など分かり易く記事にしていきますので今後とも宜しくお願いします。

一緒に楽しくAIについて学びましょう。