ディープラーニングで画像サイズを2の倍数にする理由とは?効率的な学習のための画像前処理

初めに

ディープラーニングのお悩みに回答するね

この記事では、ディープラーニングにおける画像分類や画像生成で扱う画像のサイズについて、筆者の経験に基づいた具体的な例を交えて詳しく説明していきます。

ディープラーニングにおいて、画像を扱う際にそのサイズをどう設定するかは非常に重要です。特に、画像のサイズを「2の倍数」にすることが推奨される理由と、その具体的な方法について説明します。これからディープラーニングを始める方や、既に取り組んでいる方に役立つ情報をお届けします。

この記事を読めばわかること

この記事を通して、以下のことが理解できるようになります。

- なぜ画像サイズを2の倍数にする必要があるのか:計算効率やメモリの最適化などの観点から、その重要性を解説します。

- 2の倍数でない画像サイズの問題点:オートエンコーダを例に、実際にどのような問題が発生するかを具体的に説明します。

- 画像サイズを2の倍数にする方法:リサイズやトリミングといった具体的なアプローチを紹介します。

- 高解像度画像と低解像度画像のメリット・デメリット:それぞれの利点と欠点を理解し、目的に応じた選択ができるようにします。

本記事の対象者

- ディープラーニングの基本的な知識を持っている方

- 自分でモデルを構築して学習させている方

- 画像データのサイズについて悩んでいる方

画像データの適正なサイズは2の倍数

ディープラーニングにおいて、画像データのサイズは2の倍数にするのが一般的です。例えば、32x32、64x64、128x128などのサイズが推奨されます。

2の倍数とする理由

ディープラーニングで画像サイズを2の倍数に設定するのは、以下のような理由からです。

- モデル構造を分かり易くするため:ディープラーニングでは、画像データを各層で形状変更します。この際に2の倍数で無いと次元の計算が難しくなります。そのためモデル構造を分かり易くするため、画像サイズは2の倍数にするのが一般的です。

- 計算の効率化: ディープラーニングでは、画像データが各層間で徐々に小さくなるように形状変更が行われます。2の倍数にすることで、この形状変更処理が効率的に行われ、計算速度が向上します。

- メモリ効率: 2の倍数の画像サイズは、メモリ割り当てを効率化し、メモリ使用量を削減できます。特に、大量の画像データを扱う場合に有効です。

- GPU アクセラレーション: 多くのGPUは、2の倍数のサイズに最適化されており、2の倍数の画像サイズを使用することで、GPUアクセラレーションによる高速化が期待できます。

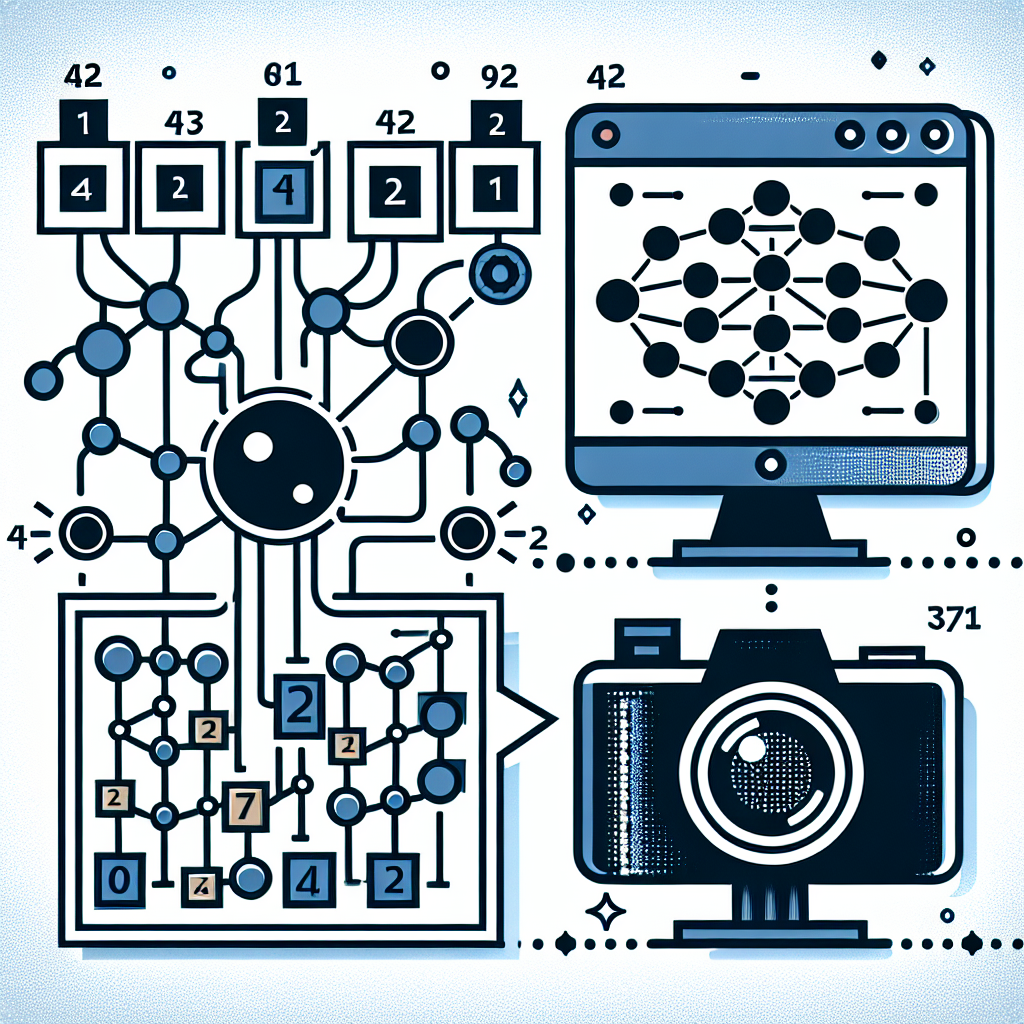

計算が複雑になる例: オートエンコーダ

筆者の経験として、画像サイズを2の倍数に設定しなかった場合に、オートエンコーダで問題が生じたことがあります。オートエンコーダは、画像を圧縮し、それを元に復元するモデルですが、サイズが2の倍数でないと、入力と出力のサイズが一致せず、うまく学習が進まないことがあります。

例えば、70x70ピクセルの画像を処理しようとすると、途中でサイズが2で割り切れなくなり、誤差が生じてしまうのです。このような問題を避けるためにも、画像サイズを2の倍数にすることが重要です。

画像サイズが2の倍数のオートエンコーダ

from tensorflow.keras.layers import Conv2D, MaxPooling2D, UpSampling2D, Flatten, Dense, Reshape

from tensorflow.keras.models import Model

# エンコーダ

encoder_input = Input(shape=(64, 64, 3)) # 入力: 64x64x3

# エンコーダの層

x = Conv2D(32, (3, 3), activation='relu', padding='same')(encoder_input) # 出力: 64x64x32

x = MaxPooling2D((2, 2))(x) # 出力: 32x32x32

x = Conv2D(64, (2, 2), activation='relu', padding='same')(x) # 出力: 32x32x64

x = MaxPooling2D((2, 2))(x) # 出力: 16x16x64

# 潜在表現

encoded = Flatten()(x) # 出力: 16384

# デコーダ

decoder_input = Input(shape=(16384,)) # 入力: 16384

# デコーダの層

x = Dense(16 * 16 * 64, activation='relu')(decoder_input) # 出力: 16*16*64

x = Reshape((16, 16, 64))(x) # 出力: 16x16x64

x = Conv2D(64, (2, 2), activation='relu', padding='same')(x) # 出力: 16x16x64

x = UpSampling2D((2, 2))(x) # 出力: 32x32x64

x = Conv2D(32, (3, 3), activation='relu', padding='same')(x) # 出力: 32x32x32

x = UpSampling2D((2, 2))(x) # 出力: 64x64x32

decoded = Conv2D(3, (3, 3), activation='sigmoid', padding='same')(x) # 出力: 64x64x3

# エンコーダとデコーダを組み合わせる

encoder = Model(encoder_input, encoded)

decoder = Model(decoder_input, decoded)

# オートエンコーダモデル

autoencoder = Model(encoder_input, decoder(encoder(encoder_input)))画像サイズが2の倍数ではないオートエンコーダ

from tensorflow.keras.layers import Conv2D, MaxPooling2D, UpSampling2D, Flatten, Dense, Reshape

from tensorflow.keras.models import Model

# エンコーダ

encoder_input = Input(shape=(70, 70, 3)) # 入力: 70x70x3

# エンコーダの層

x = Conv2D(32, (3, 3), activation='relu', padding='same')(encoder_input) # 出力: 70x70x32

x = MaxPooling2D((2, 2))(x) # 出力: 35x35x32

x = Conv2D(64, (2, 2), activation='relu', padding='same')(x) # 出力: 35x35x64

x = MaxPooling2D((2, 2))(x) # 出力: 17x17x64

# 潜在表現

encoded = Flatten()(x) # 出力: 18496

# デコーダ

decoder_input = Input(shape=(18496,)) # 入力: 18496

# デコーダの層

x = Dense(17 * 17 * 64, activation='relu')(decoder_input) # 出力: 17*17*64

x = Reshape((17, 17, 64))(x) # 出力: 17x17x64

x = Conv2D(64, (2, 2), activation='relu', padding='same')(x) # 出力: 17x17x64 ← ここで丸めが発生している

x = UpSampling2D((2, 2))(x) # 出力: 34x34x64

x = Conv2D(32, (3, 3), activation='relu', padding='same')(x) # 出力: 34x34x32

x = UpSampling2D((2, 2))(x) # 出力: 68x68x32

decoded = Conv2D(3, (3, 3), activation='sigmoid', padding='same')(x) # 出力: 68x68x3

# エンコーダとデコーダを組み合わせる

encoder = Model(encoder_input, encoded)

decoder = Model(decoder_input, decoded)

# オートエンコーダモデル

autoencoder = Model(encoder_input, decoder(encoder(encoder_input)))この例では、元の画像が70x70ですが、デコーダの出力は68x68になっています。これは、途中で次元が2で割り切れず、丸められたために起こります。入力と出力の画像サイズが異なるため、エラーが発生してしまいます。

画像サイズを2の倍数にする方法

ディープラーニングにおける画像の前処理として、画像サイズを変更する必要がある場合、リサイズとトリミングという2つの方法があります。それぞれにメリットとデメリットがあるので、用途に合わせて適切な方法を選択する必要があります。

リサイズ

リサイズとは、画像の解像度を変更することによって、画像のサイズを変更する方法です。つまり、画像を拡大または縮小します。

メリット

- 元の画像の全体像を維持できる: 画像全体の情報が保持されるため、全体的な特徴を捉えたい場合に有効です。

- 任意のサイズに変更できる: 必要なサイズに柔軟に対応できます。

デメリット

- 解像度が低下する可能性: 画像を縮小すると、解像度が低くなり、細かい情報が失われる可能性があります。

- 縦横比が変わる可能性: 元の画像の縦横比が維持されない場合、画像が横長や縦長になってしまい、見た目が悪くなることがあります。

トリミング

トリミングとは、画像の一部を切り取り、不要な部分を削除して画像のサイズを変更する方法です。画像の解像度は変更されません。

メリット

- 解像度が維持される: 画像を切り取るだけなので、元の解像度が保持されます。

- 不要な部分を削除できる: 不要な部分を削除することで、学習に不要な情報を排除できます。

デメリット

- 画像の一部が欠落する: 不要な部分だけでなく、必要な情報も削除されてしまう可能性があります。

元の

リサイズのサンプルコード

from PIL import Image

# 画像を開く

image = Image.open(image_path)

# リサイズ

resized_image = image.resize((new_width, new_height))

# リサイズされた画像を保存

resized_image.save('resized_image.jpg')トリミングのサンプルコード

from PIL import Image

# 画像を読み込む

image = Image.open("image.jpg")

# トリミングする領域を指定 (left, top, right, bottom)

left = 100

top = 50

right = 300

bottom = 200

# 画像をトリミングする

cropped_image = image.crop((left, top, right, bottom))

# トリミングされた画像を保存する

cropped_image.save("cropped_image.jpg")ディプラーニングにおける画像サイズのその他の考慮事項

画像サイズは機械学習において重要な要素であり、適切な画像サイズを選択することで、モデルの性能向上、学習時間短縮、メモリ消費量削減などのメリットが得られます。一方で、画像サイズを適切に扱わないと、精度低下や学習の失敗に繋がることがあります。

高解像度画像

メリット

- 細部情報が豊富で、モデルがより複雑な特徴を学習できる可能性があります。

- 高解像度画像の方が、細かい物体やパターンを識別できる場合があります。

デメリット

- 学習データ量が増加し、学習時間が長くなる傾向があります。

- メモリ消費量が増加し、計算資源の制約を受ける場合があります。

- モデルの複雑さが増し、過学習のリスクが高まります。

低解像度画像

メリット

- 学習データ量が減少し、学習時間が短縮されます。

- メモリ消費量が減少し、計算資源の制約を受けにくくなります。

- モデルの複雑さが減少し、過学習のリスクが低くなります。

デメリット

- 詳細情報が失われ、モデルが重要な特徴を学習できない可能性があります。

- 低解像度画像では、細かい物体やパターンを識別することが難しくなります。

本記事のまとめ

ディープラーニングでの画像サイズは、モデルの性能に大きな影響を与えます。画像サイズを2の倍数にすることで、効率的な学習とモデルのパフォーマンス向上が期待できます。また、リサイズやトリミングの方法を理解し、適切に画像を処理することが重要です。

一緒にAIを学びながら、楽しくスキルを磨いていきましょう。